Deepfake to coraz większy problem, ale to rozwiązanie ma zapobiec chaosowi

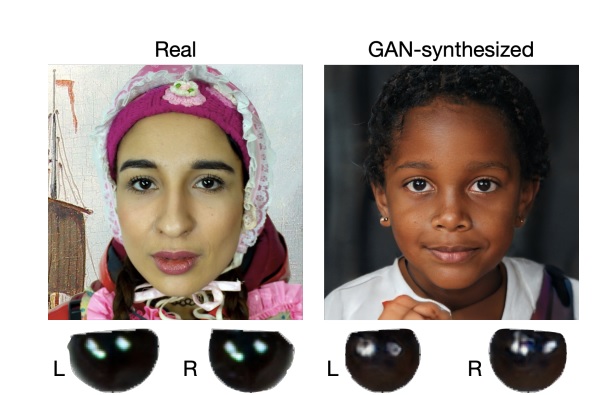

Czy te oczy mogą kłamać? Chyba tak, jednak amerykańscy naukowcy są w stanie namierzyć fejki ze skutecznością do 94%.

Deepfake, czyli wykorzystanie uczenia maszynowego do tworzenia zmanipulowanych materiałów wizualnych, w których w usta dowolnej postaci możemy włożyć dosłownie wszystko, to jeden z najbardziej newralgicznych problemów w świecie nowych technologii. Jeśli “fake newsy” w ostatnich latach stały się kwestią poruszaną w kontekście bezpieczeństwa największych światowych demokracji, to deepfake’i można uznać za fake newsy na dopalaczach – tymczasem do tej pory brakowało skutecznych narzędzi do walki ze zjawiskiem.

Zmienić ma to nowy system, opracowany przez naukowców z Uniwersytetu w Buffalo, którzy stwierdzili, że także w przypadku deepfake’ów kluczowa jest odpowiedź na pytanie “czy te oczy mogą kłamać?”. Rozwiązanie bazuje na analizie rogówek, które dzięki lustrzanej powierzchni po doświetleniu źródłem zewnętrznym generują na swojej powierzchni określone wzory. Dzięki patrzeniu w ten sam punkt, na obu gałkach ocznych powinny pojawić się podobne wzorce – czego na razie bazująca generatywne sieci przeciwstawne (GAN) nie nauczyły się naśladować w wystarczającym stopniu.

Czytaj też: Japoński profesor stworzył ekran, który możesz polizać, by poczuć pokazywane danie

Dzięki niespójnościom wykazanym w procesie mapowania twarzy system wykazuje 94% skuteczność w rozpoznawaniu deepfake’ów, jednak na razie ma też pewne ograniczenia. Dotyczą one przede wszystkim tego, że jest stworzony do analizy twarzy – w przypadku fałszywych obrazów, na których nie widzimy osoby przemawiającej do nas prosto w oczy, narzędzie okaże się nieskuteczne. Naukowcy pracują jednak nad jego rozbudową – tak, by wczesne wykrywanie zagrożenia ochroniło nas przed wzywającym do rozpoczęcia wojny fejkowym politykiem.

Źródło: The Next Web, grafika: Shu Hu, Yuezun Li, Siwei Lyu/ University at Buffalo